Über das Projekt EERIE

Das EERIE-Projekt entwickelt eine neue Generation von Erdsystemmodellen (ESMs), die mit einer räumlichen Auflösung von 10 km in der Atmosphäre und 5 km im Ozean arbeiten. Damit sollen Klimareaktionen und -schwankungen in einem wirbelreichen Ozean untersucht werden. Dieser Maßstab wird auch als mesoskalig bezeichnet und ist für das Erdsystem von zentraler Bedeutung. Zum einen beeinflussen mesoskalige Ozeanwirbel den Transport von Wärme, Süßwasser und Stoffen wie Kohlenstoff – insbesondere in die tieferen Ozeanschichten. Zum anderen verstärken mesoskalige Fronten die Wechselwirkungen zwischen Atmosphäre und Ozean. Dadurch wirken sie sich direkt auf atmosphärische Variabilität und Klimaextreme aus.

Dank moderner wissenschaftlicher und technologischer Entwicklungen konnte EERIE erstmalig das Erdsystem über ein ganzes Jahrhundert hinweg mit einer wirbelauflösender Ozeankomponente simulieren. Unten sind zwei Videos mit Visualisierungen eingebunden, die auf den EERIE-Simulationen des MPI-M mit dem ICON-Modell beruhen. Weitere Beispiele finden sich auf dem DKRZ-Youtube-Kanal. Ein ausgewählter Teil der EERIE-Daten wird zusätzlich auf etablierten Plattformen wie dem ESGF am DKRZ oder dem WDCC bereitgestellt.

In den vergangenen Jahren hat die Klimamodellierung einen beeindruckenden Sprung nach vorn gemacht – insbesondere bei der Entwicklung von Erdsystemmodellen (ESMs) mit Auflösungen im Kilometerbereich. Diese Modelle arbeiten mit räumlichen Gitterweiten von etwa 10 Kilometern oder sogar feiner. Auf diesem Niveau werden sie „eddy-rich“, weil sie auch kleinräumige Strukturen im Ozean und Atmosphäre wie Wirbel, Jets oder Konvektionssysteme direkt abbilden können. In gröber aufgelösten Modellen müssen solche Phänomene meist über Parametrisierungen angenähert werden.

Da Wirbel-reiche Modelle weniger Vereinfachungen benötigen und physikalische Prozesse detaillierter darstellen, liefern sie langfristig Klimadaten von höherer Genauigkeit. Das ist besonders wichtig, um regionale Extreme, Wechselwirkungen zwischen Ozean und Atmosphäre sowie atmosphärische Dynamiken noch präziser und umfassender untersuchen zu können.

Die folgenden beiden Videos zeigen Visualisierungen von km-skaligen ICON-Simulationen des Max-Planck-Instituts für Meteorologie, die im Rahmen von EERIE durchgeführt wurden:

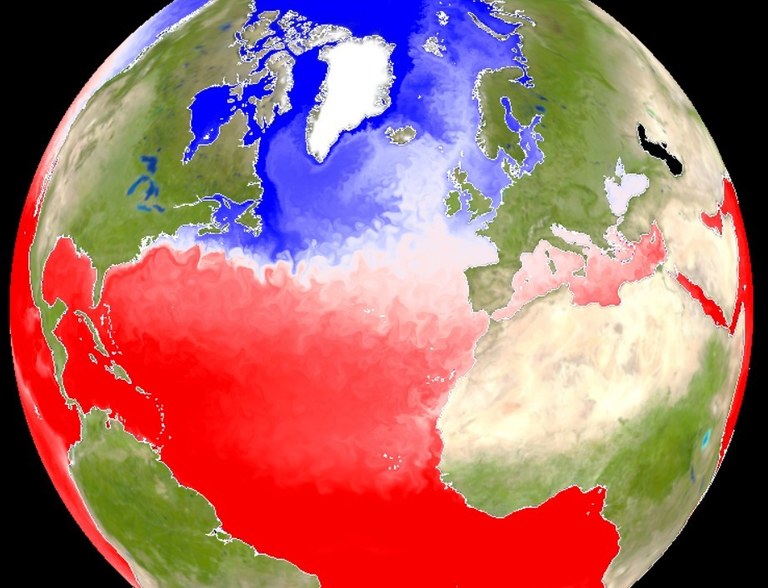

Video 1: Km-skalige ICON-Klimasimulation über 100 Jahre: Die Visualisierung zeigt die Veränderung zweier wichtiger Klimagrößen bei einer globalen Auflösung von 10 km für die Atmosphäre und 5 km für den Ozean. Für den Zeitraum von 1950 bis 2014 basiert der Antrieb auf historischen CO2-Konzentrationen; ab dann wurde das „Middle of the Road”-Szenario SSP2-4.5 vorgegeben. Der Globus auf der rechten Seite zeigt einen laufenden 10-Jahres-Durchschnitt der Temperaturänderung gegenüber 1950-1960. Dazu zeigt das obere Diagramm links die mittlere globale 2-m-Temperaturanomalie. Die simulierte mittlere Erwärmung im Jahr 2050 gegenüber 1950–1960 beträgt etwa 1,6 °C. Gleichzeitig wird die zeitliche Entwicklung der AMOC (Atlantic Meridional Overturning Circulation) dargestellt: Die meridionale Stromfunktion für das Atlantikbecken wird unten links angezeigt, während die Veränderung der AMOC-Stärke im Vergleich zum Mittelwert von 1950-1960 in der Mitte links dargestellt ist. Insgesamt sinkt die Stärke der AMOC über den Simulationszeitraum um etwa 2 Sv.

Video 2: Diese Visualisierung zeigt die Salzgehaltverteilung und Strömungsgeschwindigkeit der Meeresoberfläche über einen Zeitraum von zehn Jahren einer gekoppelten 100-Jahre Klimasimulation auf der Kilometerskala mit ICON. Die Einfärbung des Ozeans zeigt den Salzgehalt an der Oberfläche, während die Schattierung gleichzeitig die Geschwindigkeit zeigt. So sind die sich langsam fortbewegenden Ozeanwirbel gut erkennbar, aber auch die sich schnell bewegenden Spuren von Stürmen. Während der Animation wird der Globus langsam geneigt, so dass die Variabilität und der Jahreszyklus der Meeresströmungen für beide Hemisphären beobachtet werden können. Gerade im Salzgehalt sind in den Tropen viele kleinräumige Muster zu sehen, die etwa auf kleinere Niederschlagsgebiete zurückzuführen sind. Für die Simulation wurde ICON mit einer globalen Auflösung von 10 km für die Atmosphäre und 5 km für den Ozean verwendet.

Virtuelle Datensätze: Schneiden statt Kleben

Um zu verstehen, warum der Umgang mit ESM-Daten im Kilometer-Maßstab so anspruchsvoll ist, lohnt ein Blick auf ihre Entstehung. Eine globale Simulation über mehrere Jahrzehnte mit 10-km-Auflösung erzeugt schnell mehrere Petabyte an Ausgabedaten für ein einzelnes Experiment. Die großen Gitter, die Vielzahl an Variablen und die vielen Zeitschritte führen zu zehntausenden individuellen Dateien für die einzelnen Modellkomponenten. Jede Datei enthält nur einen winzigen Ausschnitt des Gesamtbildes. Diese Dateiflut macht es extrem schwierig, Analysen durchzuführen, die große räumliche oder zeitliche Skalen umfassen. Tausende Dateien müssen geöffnet und eingelesen werden – eine aufwändige und I/O-lastige Prozedur.

Hinzu kommt, dass das traditionelle Format NetCDF bei Klimadaten in km-Skala einige Ineffizienzen zeigt. Viele Dateien enthalten redundante Metadaten, zum Beispiel wiederholte Koordinatenangaben. Diese Duplizierung kann den Gesamtspeicherbedarf um 10 % oder mehr erhöhen – bei Petabyte-Datenmengen ein beträchtlicher Mehraufwand. Um diese Daten als durchgehenden Datensatz zu analysieren oder visualisieren, müssen Forschende sie obendrein oft zu einem großen Dateiobjekt zusammenführen – ein Vorgang, den man bildlich als „Verkleben“ tausender Puzzleteile verstehen kann. Dieses Verkleben ist zeitaufwendig, benötigt zusätzlichen Speicher und muss von jeder Person, die mit dem gleichen Experiment arbeitet, erneut durchgeführt werden.

Zarr - ein modernes Datenformat und Zugriffsinterface

Eine NetCDF-Datei kann man sich wie ein gedrucktes Buch vorstellen – etwa einen Band einer Enzyklopädie. Jede Seite enthält Daten, während Umschlag, Einleitung und Glossar Metadaten und Erläuterungen bereitstellen. Das Buch ist in sich abgeschlossen und selbsterklärend, aber zugleich schwer und unhandlich. Ein hochaufgelöstes Erdsystemmodell (HR-ESM) würde quasi Millionen solcher Enzyklopädiebände erzeugen – jedes davon umfangreich, mit dickem Einband und langem Glossar. Sie stehen dicht an dicht im Regal; und selbst wenn man nur ein paar Einträge benötigt, muss man jedes Mal den gesamten Band herausnehmen.

Zarr dagegen ergänzt diese Bände durch ein Archiv, das jede Seite aller Bücher verwaltet und einzeln lesbar macht. Dadurch lassen sich gezielt nur die benötigten Abschnitte herausgreifen oder neue Bände zusammenstellen, die Kapitel aus verschiedenen Originalen nahtlos kombinieren. Auf diese Weise entstehen virtuelle Enzyklopädiebände, die die gesamte Sammlung abdecken, ohne dass je ein ganzer schwerer Wälzer hochgehoben werden muss. Damit bringt Zarr die Flexibilität einer gut organisierten Bibliothek in die Welt des Klimadaten-Managements.

Virtuelle Datasätze bieten eine deutlich elegantere, leichtgewichtigere Alternative. Statt Dateien physisch zusammenzufügen, bleiben sie getrennt, werden aber über eine gemeinsame Metadaten-Ebene als ein Datensatz beschrieben. Realisiert wird dieses Konzept mit Zarr, einem modernen Datenformat und Zugriffsinterface, das speziell für Cloud- und HPC-Umgebungen entwickelt wurde. Zarr erlaubt es, viele bestehende Dateien – auch solche, die ursprünglich nicht im Zarr-Format vorliegen – zu einem kohärenten „virtuellen Datensatz“ zu bündeln.

„Virtuell“ bedeutet dabei: Die Daten müssen weder kopiert noch verschoben werden. Eine Metadatenbeschreibung verweist lediglich darauf, wo Variablen, Zeitschritte oder räumliche Teilstücke in den Originaldateien abgelegt sind. Die Metadaten werden einmalig gespeichert, die Daten verbleiben an ihrem ursprünglichen Speicherplatz. Nutzende können den virtuellen Datensatz anschließend über eine einzige Schnittstelle – die Zarr-Bibliothek – öffnen, als handele es sich um eine große Datei. Und sie können dies unterteilen oder auf bestimmte Teilmengen zugreifen, etwa eine einzelne Variable, eine Region oder ein Jahrzehnt, ohne zuvor den gesamten Datensatz zusammenstellen oder einlesen zu müssen.

Der Paradigmenwechsel von „Kleben“ zu „Schneiden“ verändert alles: Lange Preprocessing-Schritte und lokale Kopien von zusammengeführten Datensätzen sind nicht mehr erforderlich. Gleichzeitig müssen nur die wirklich benötigten Daten geladen werden – bedarfsgerecht, schnell und ressourcenschonend. Auch das Datenmanagement profitiert: Eine zentrale Metadatenebene statt tausender zusammengefügter Dateien vereinfacht Aktualisierungen und gewährleistet Konsistenz über Experimente hinweg.

Genau so verarbeitet EERIE km-skalige Modelldaten. Für jede Simulation erzeugt EERIE Zarr-basierte virtuelle Datensätze und erfasst sie in durchsuchbaren Katalogen. Sie werden mit wertvollen Metadaten wie Koordinaten, Variablenattribute und Experimentbeschreibungen ergänzt. Dadurch stehen sie direkt für Analysen bereit und gleichzeitig bleiben die Rohdaten vollständig erhalten.

Die Kataloge dienen als strukturierte Zugangspunkte: Sie listen alle verfügbaren virtuellen Datensätze auf und enthalten Gebrauchsanweisungen für deren Zugriff. Analysewerkzeuge erhalten dadurch exakt die Informationen, die sie zum Öffnen eines Datensatzes benötigen. Nutzende können Daten direkt aus dem Katalog herausfiltern, öffnen und analysieren – ohne Zusatzinformationen oder spezielle Konfigurationsdateien.

Alle Skripte und Konfigurationsvorlagen zur Erzeugung virtueller Datensätze stellt EERIE frei verfügbar (open-source) auf GitLab bereit. Durch dieses transparente Vorgehen können andere Projekte den Ansatz problemlos übernehmen.

Das Ergebnis ist ein wesentlich effizienterer Umgang mit hochaufgelösten Klimadaten. Wissenschaftler:innen müssen nicht mehr Dateien „verkleben“, sondern können sich nun direkt ihren Forschungen widmen – indem sie umfangreiche Modellausgaben über eine einheitliche, optimierte Schnittstelle untersuchen, vergleichen und analysieren. Besucht unsere Dokumentation auf der easy.gems-Plattform — dort werdet ihr durch die Welt der EERIE-Daten geführt.

Cloudify: Ein Cloud-Speicher-Emulator

Daten in eine Cloud zu verlagern (wie man es etwa von Google- oder Amazon-Diensten kennt), wäre theoretisch die einfachste Möglichkeit, um die Ergebnisse von Erdsystemmodellen (ESM) sowohl für Datenanbieter als auch für Datenproduzenten zu verbreiten und deren Wirkung zu erhöhen. Cloud-Speicher ist flexibel und einfach zu nutzen – im Gegensatz zu den komplizierteren, klassischen Serverlösungen vor Ort. Daher unterstützt das DKRZ die Gemeinschaft bei der Vorbereitung und Erprobung eines neuen S3-Cloud-Speicherdienstes.

Damit ESM-Outputs effizient über die Cloud zugänglich sind, müssen sie jedoch in einem cloud-optimierten Format vorliegen.

Für EERIE scheint dies naheliegend, da durch die virtuellen Datensätze bereits ein erster Schritt in Richtung Zarr getan wurde – und Zarr ist speziell für die Cloud konzipiert. In der Praxis gibt es jedoch Hürden:

- Institutionelle Cloud-Ressourcen sind begrenzt – auch am DKRZ.

- Die Umwandlung älterer Formate wie NetCDF oder GRIB in optimal strukturierte Zarr-Datasets ist rechenintensiv und zeitaufwendig. Dies erfordert eine sorgfältige Abstimmung zwischen Datenproduzenten und -nutzern.

- Oft verbleiben die Originiale als Kopien auf HPC-Systemen gespeichert – ein Umzug in die Cloud würde die Daten verdoppeln und kostbaren Speicherplatz verschwenden.

Um diese Probleme anzugehen, entwickelte das DKRZ-Team mit Cloudify (Wachsmann et al., 2025) einen Cloud-Speicher-Emulator auf Basis von xpublish. Dieses Open-Source-Framework stellt Datensätze über Web-Protokolle bereit – mit Zarr-kompatiblen Endpunkten. Anstatt Daten physisch in die Cloud zu kopieren, sorgt Cloudify dafür, dass lokale Datensätze sich so verhalten, als befänden sie sich bereits in der Cloud. Über eine REST-API erscheinen sie wie klassischer Cloud-Speicher – obwohl sie weiterhin auf lokalem HPC-Speicher liegen. Forschende und Werkzeuge können dadurch mit den Daten arbeiten, ohne dass die Kosten oder die Komplexität einer vollständigen Datenmigration anfallen.

Cloudify wurde zunächst auf einer virtuellen Maschine namens eerie.cloud (Wachsmann et al. 2026, Publikation in Vorbereitung) als experimenteller Dienst eingesetzt, um offenen und standardisierten Zarr-Zugang zu allen EERIE-Simulationen zu bieten. Was als kleine Machbarkeitsstudie begann, entwickelte sich rasch zu einer leistungsstarken Brücke zwischen HPC- und Cloud-Workflows. Forschende konnten Petabytes hoch-aufgelöster Klimadaten mit vertrauten Cloud-Werkzeugen durchsuchen, während die Daten nicht in der Cloud sondern auf dem HPC-System gespeichert sind. Inzwischen hat sich eerie.cloud zu einem produktionsreifen Gemeinschaftsdienst entwickelt – welcher von Projekten wie NextGEMs, Orcestra und DYAMOND genutzt wird – und entwickelt sich zum dedizierten „km-scale-Cloud“-Angebot des DKRZ. Nahezu 6 Petabyte an EERIE-Simulationsdaten (Speicherbedarf im Arbeitsspeicher) stehen über eerie.cloud zur Verfügung (siehe Tabelle 1) – mehr, als das DKRZ als fairen Cloud-Anteil auf dem S3-Speicher für Projekte überhaupt bereitstellen könnte.

Für Wissenschaftler:innen bedeutet dies: nahtloser, nahezu sofortiger Zugriff auf komplexen Modell-Output – ohne Downloads oder Datei zusammenzuführen. Für Datenanbieter bietet es eine skalierbare und effiziente Methode, ihre Ergebnisse auffindbar und wiederverwendbar zu machen. Und für die breitere Gemeinschaft zeigt eerie.cloud, wie sich bestehende HPC-Infrastruktur durch smarte Software in eine offen zugängliche, cloud-ähnliche Umgebung verwandeln lässt – und so hochmoderne Klimasimulationen für alle greifbar macht.

|

Projekt |

Datensatz |

Quell- format |

Gesamtspeichergröße [Terabyte] |

Auflösung [km] |

| ORCESTRA | 104 | Zarr | 30 | 1 |

| ERA5 | 7 | GRIB | 373 | 28 |

| Cosmo-rea | 12 | NetCDF | 118 | 12 |

| nextGEMS | 35 | Mixed | 3058 | 5 |

| EERIE | 386 | Mixed | 5895 | 10 |

| Dyamond | 16 | Mixed | 232 | 2 |

| Summe | 560 | 9706 |

Tabelle 1: Projekt-Datensätze, die seit Juli 2025 über die km-scale-Cloud verfügbar sind.

Kataloge: DKRZ -Datenspeicher entdecken

Nachdem der Zugriff auf Klimamodell-Daten im Kilometer-Maßstab durch virtuelle Datensätze und Cloudify deutlich vereinfacht und „cloud-ready“ gemacht wurde, bleibt die Auffindbarkeit als letzte große Herausforderung bestehen. Selbst wenn die Daten technisch verfügbar sind, verliert man leicht den Überblick. Welche Experimente existieren? Wo liegen sie? Wie werden sie geöffnet? Bei Hunderten von Experimenten, Modellversionen, Variablen und Auflösungen wirkt die Welt hochaufgelöster Simulationen schnell wie ein großes, unübersichtliches Archiv. Den richtigen Datensatz zügig und sicher zu finden, ist dabei ebenso wichtig wie ein effizienter Zugriff.

An dieser Stelle kommen Kataloge ins Spiel. Im Daten-Workflow von EERIE navigieren side die Datennutzenden durch die Datenlandschaft. Sie beschreiben jeden Datensatz, erklären, wie er geöffnet wird, und verknüpfen verwandte Experimente zu einer navigierbaren Struktur.

Zu Beginn nutzte die EERIE-Datenpipeline Intake, ein einfaches, leichtgewichtiges Katalogisierungswerkzeug, das hervorragend mit Python-Analysetools harmoniert. Mit nur wenigen Zeilen Code – oft weniger als zehn – konnten Datenanbieter festlegen, wo ein Datensatz liegt, wie er strukturiert ist und wie er geöffnet werden kann. Diese Angaben verwiesen direkt auf die virtuellen Datensätze im EERIE-Intake-Katalog (Wachsmann et al., 2024). Sobald ein Katalogeintrag definiert war, ließ er sich unmittelbar aus Python-Skripten und Jupyter-Notebooks heraus abfragen. Ein einzelner Funktionsaufruf genügte, um einen kompletten Datensatz im Kilometer-Maßstab zu laden – der Weg von Metadaten zur Analyse dauerte nur Sekunden. Für die EERIE-Wissenschaftler:innen wurde es dadurch besonders einfach, Workflows zu testen, neue Diagnostiken auszuprobieren oder automatisierte Analysen durchzuführen, ohne die Daten manuell verarbeiten zu müssen.

Mit der Zeit traten jedoch Grenzen von Intake hervor: Es bietet keine grafische Oberfläche, neue Versionen sind nicht rückwärtskompatibel, und die Zusammenarbeit mit Werkzeugen außerhalb der Python-Welt ist umständlich. Um die Kataloge offener, langlebiger und breiter einsetzbar zu machen, braucht es einen allgemeineren Ansatz, der Sprachen, Plattformen und Nutzergruppen verbindet.

Daher entschloss sich das EERIE-Team, zusätzlich den STAC-Standard (SpatioTemporal Asset Catalog, STAC) zu unterstützen. STAC wurde ursprünglich für Erdbeobachtungsdaten entwickelt, hat sich aber mittlerweile zu einem flexiblen, domänenübergreifenden Metadatenframework entwickelt, das beliebige räumliche oder zeitliche Datensätze beschreiben und indexieren kann. Es ist sowohl für Menschen als auch Maschinen gut lesbar, über grafische Oberflächen zugänglich und über APIs automatisiert durchsuchbar.

Das DKRZ entwickelt in Projekten wie WarmWorld eine STAC-basierte Infrastruktur weiter, um eine solide Grundlage für die Auffindbarkeit, Suche und Zugänglichkeit wissenschaftlicher Daten über wissenschaftlichen Domaingrenzen hinweg zu schaffen. Die entstehende DKRZ-STAC-Welt kann bereits über https://discover.dkrz.de erkundet werden.

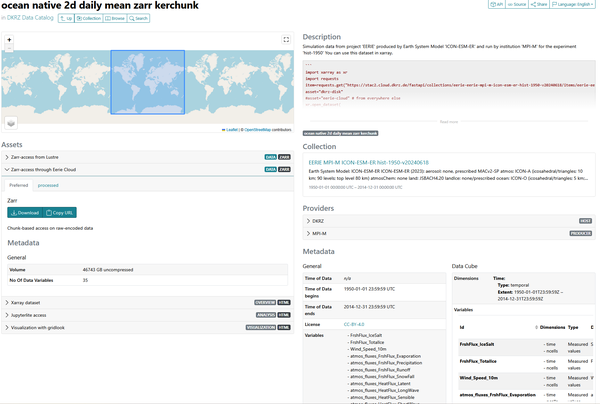

Innerhalb von EERIE wurde die Basis gelegt, um km-skalierte ESM-Daten künftig effizient in STAC abzubilden. Das Team entwickelte STAC-”Item”-Vorlagen, die speziell auf die virtuellen Datensätze zugeschnitten sind. Jeder Datensatz wird durch umfangreiche Metadaten beschrieben – darunter Experimentinformationen, Koordinaten und direkte Zugangs-URLs. Abbildung 1 zeigt den Blick auf ein solches Item im STAC-Browser.

Abbildung 1: EERIE-STAC-Eintrag für einen ICON-Datensatz mit täglichen Ozeanvariablen, wie er im Webbrowser dargestellt wird. Die Ansicht zeigt, wie der Datensatz geöffnet werden kann und welche Inhalte er umfasst.

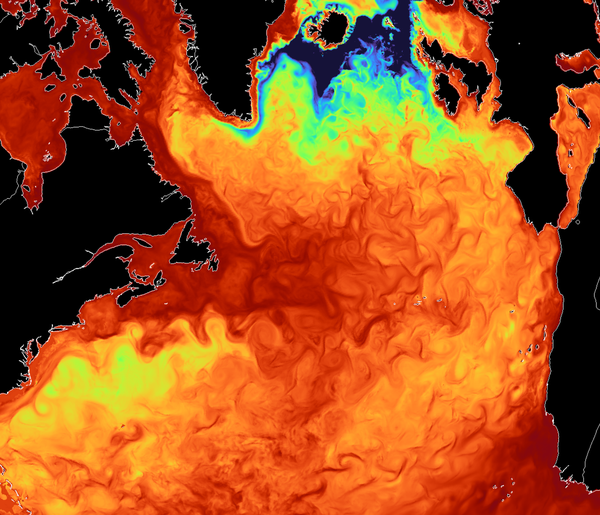

Die Einträge enthalten außerdem Codebeispiele für den programmgesteuerten Zugriff sowie Links zu Open-Source-Werkzeugen und Visualisierungen (siehe Abbildung 2), die direkt mit den Daten arbeiten. Dadurch werden sie nicht nur besser auffindbar, sondern unmittelbar nutzbar. Anschließend wurden die Items zu STAC-Kollektionen zusammengeführt, zum Beispiel eine Kollektion für das ICON-Experiment hist-1950.

Abbildung 2: Die Tiefe der durchmischten Schicht im Nordatlantik in der ICON-Simulation EERIE hist-1950 mit ~5-km-Auflösung, visualisiert mit gridlook. Wer mehr als 100 MB herunterladen kann, kann diese Grafik über den angegebenen Weblink. selbst erzeugen. Sie wird auf der lokalen GPU aus einem Zeitschritt des virtuellen Datensatzes gerendert, der live über eerie.cloud bereitgestellt wird.

Nutzer:innen erwartet auf https://eerie.cloud.dkrz.de eine durchsuchbare Oberfläche der gesamten EERIE-Hauptkollektion – ein strukturiertes, dynamisches Verzeichnis, das alle Experimente, Datensätze und Werkzeuge enthält. Hinter den Kulissen wird dieser Katalog laufend aktualisiert: mit jeder neuen Simulation, jedem weiteren Experiment und jedem frisch erzeugten Metadatensatz aus der EERIE-Pipeline.

Die Zukunft des Klimadatenmanagements

Virtuelle Datensätze, Cloudify und Kataloge bilden gemeinsam das Rückgrat des EERIE-Datensystems. Die virtuellen Datensätze machen km-skalierte Klimamodell-Ausgaben nutzbar, Cloudify macht sie zugänglich, und die Kataloge machen sie auffindbar. Diese Pipeline verwandelt eine zuvor unübersichtliche Ansammlung von Bytes in eine konsistente, durchsuchbare und offen zugängliche Ressource für die Klimaforschung.

Für Forschende bedeutet das EERIE-Datensystem: weniger Zeit für Vorverarbeitung und Datenübertragung – und mehr Zeit für wissenschaftliche Arbeit. EERIE speichert nicht nur Daten: Es verwandelt sie in Wissen, das entdeckt werden möchte.

Diese Veröffentlichung ist Teil des von der Europäischen Union geförderten EERIE-Projekts (Grant Agreement Nr. 101081383). Die geäußerten Ansichten liegen ausschließlich bei den Autor:innen und spiegeln nicht notwendigerweise die Position der Europäischen Union oder der European Climate Infrastructure and Environment Executive Agency (CINEA) wider. Weder die Europäische Union noch die Bewilligungsbehörde übernehmen Verantwortung für den Inhalt.

Diese Arbeit wurde außerdem vom Staatssekretariat für Bildung, Forschung und Innovation (SERI) unter dem Vertrag Nr. 22.00366 unterstützt.

Zusätzlich wurde sie im Rahmen der Horizon-Europe-Fördergarantie der britischen Regierung durch UK Research and Innovation (UKRI) gefördert (Fördernummern 10057890, 10049639, 10040510, 10040984).

Literatur:

Wachsmann, Fabian; Heil, Angelika; Wickramage, Chathurika; Polkova, Iuliia; Thiemann, Hannes; Modali, Kameswarrao; Lammert, Andrea; Peters-von Gehlen, Karsten; Kindermann, Stephan (2025). Technical Overview of Cloudify - An Improved Emulator of Cloud-Optimized Earth System Model Output. World Data Center for Climate (WDCC) at DKRZ. https://doi.org/10.35095/WDCC/Overview_Cloudify

Wachsmann, F., Matthias Aengenheyster, Wickramage, C., Seddon, J., Nikolay Koldunov, & Ziemen, F. (2024). Data access to EERIE ESM output via intake catalogues: Phase1 plus Hackathon simulations (v1.0.0). Zenodo. https://doi.org/10.5281/zenodo.14243677

Autoren:

- Fabian Wachsmann, Abteilung Datenmanagement, DKRZ

- Chathurika Wickramage, Abteilung Datenmanagement, DKRZ

- Team von EERIE und der Abteilung Datenmanagement am DKRZ