Warum Klimasimulationen im Kilometermaßstab spannend sind

Typische Klimamodelle, auf deren Ergebnissen wichtige Aussagen der Sachstandsberichte des Weltklimarates IPCC beruhen, simulieren heute das Klima auf Gittern mit einer horizontalen Auflösung von etwa 100 Kilometern für Atmosphäre, Ozean und Land. Auf diesen räumlichen Skalen können viele Prozesse, die für Wetter und Klima eine entscheidende Rolle spielen, nicht direkt anhand der physikalischen Gleichungen der Modelle dargestellt werden. Die Effekte dieser Prozesse in jeder Gitterzelle werden daher mit Annahmen – sogenannten Parametrisierungen – dargestellt. Dabei wird bei der Modellierung der mittlere Effekt dieser kleinräumigen Prozesse näherungsweise für die gesamte Gitterzelle verwendet. Die dadurch entstandenen Ungenauigkeiten sind mitverantwortlich für viele Unsicherheiten, mit denen Klimaprognosen noch behaftet sind. Beispiele für solche kleinräumigen Prozesse sind Wirbel in den Ozeanen, hochreichende Quellwolken in den Tropen, feine Strukturen und vor allem Risse im Meereis. Genauso können aber auch kleinräumige geographische Strukturen, etwa die Morphologie (Topographie, Bathymetrie, Land-Meer-Verteilung, Inseln und Seen) und Beschaffenheit (Bewuchs und Bebauung) der Erdoberfläche nicht adäquat berücksichtigt werden.

Prozesse auf der Kilometer-Skala sind aus vielerlei Hinsicht spannend. Da bei einer direkten Simulation mehr Prozesse auf Basis physikalischer Beschreibungen statt auf Parametrisierungen berechnet werden, tragen die durch diese Parametrisierungen bedingten Unsicherheiten nicht mehr zu den Unsicherheiten der Klimaprojektionen bei. Beispielsweise können Wolken und Niederschlag und somit auch Starkregenereignisse in der Zukunft direkt simuliert, statt mit einem statistischen Modell angenähert werden. Die Klimaforscher:innen simulieren quasi das Wetter, was das Klima der Vergangenheit, oder Zukunft formt. Die genannten Beispiele zeigen auch, dass Prozesse auf Kilometer-Skala für den Menschen greifbarer und nicht zuletzt relevanter werden. Kleinräumige Ozeanströmungen können Fischvorkommen und somit ganze Wirtschaftszweige entlang von Küstengebieten beeinflussen. Schneedicke und Niederschlagsmengen in den Alpentälern sind nicht nur größte Faktoren für Lawinen- und Erdrutschgefahr, sondern beeinflussen auch die Flüsse sowie die Trinkwasserversorgung von der Nordsee bis an die Adria.

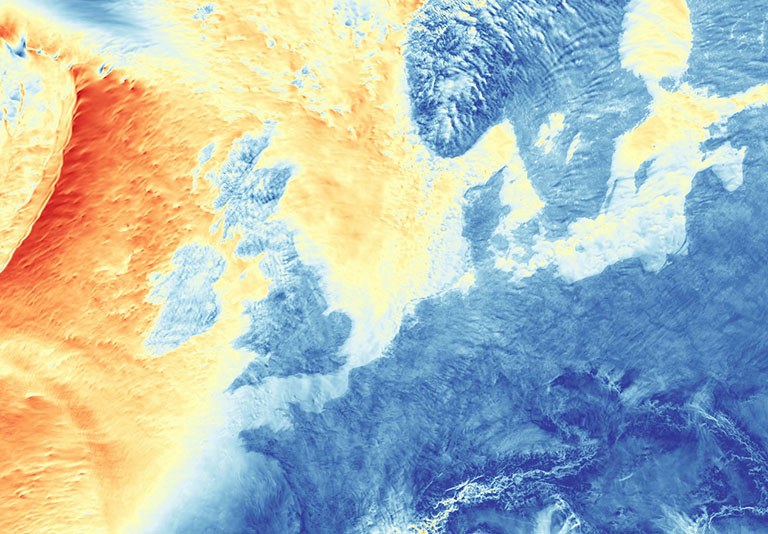

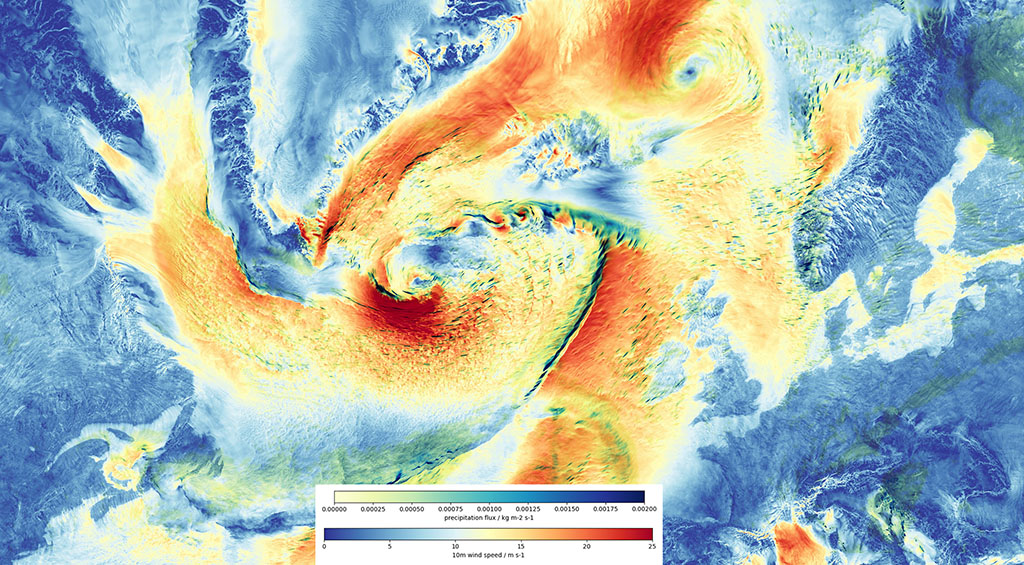

Abbildung 1: Visualisierung der 10m-Windgeschwindigkeit in blau/gelb/rot und des Niederschlags (grün) auf Basis einer mit dem gekoppelten ICON-Modell bei einer Auflösung von 1 km simulierten Wettersituation. Das dargestellte Windfeld ist durch zwei große Sturmsysteme geprägt, deren Zentren zu dem gewählten Zeitpunkt nordöstlich und südwestlich von Island zu sehen sind.

Fortschritte in der Leistungsfähigkeit und Architektur von Supercomputern ermöglichen mittlerweile die Darstellung der relevanten Prozesse in Atmosphäre und Ozean auf wenigen Kilometern. Während einzelne Ozean- oder Atmosphärenmodelle bereits Simulationen mit horizontalen Auflösungen von etwa 1 km durchführen konnten, so ist es am Max-Planck-Institut für Meteorologie zum ersten Mal weltweit gelungen, eine Simulation mit einem vollständig gekoppelten globalen Atmosphären-Ozean-Modell bzw. Erdsystemmodell durchzuführen.

Einige (große) Zahlen

Erste erfolgreiche Läufe nutzen 900 Rechenknoten und damit etwa ein Drittel der gesamten CPU-Rechenkapazität des DKRZ-Rechners Levante. Pro Tag wurden drei Simulationstage berechnet.

Die Simulationen in Zahlen:

- 340.000.000 Gitterpunkte in der Horizontalen mal 90 Ebenen in Zeitschritten von 10 Sekunden für die Atmosphäre

- 230.000.000 Gitterelemente im Ozean mal 128 Ebenen in Zeitschritten von 45 Sekunden

- 115.000.000 Gitterelemente im Land mal 5 Level in Zeitschritten von 10 Sekunden

- 200 Terabyte gespeicherte Daten für eine simulierte Woche

Diese enormen Simulationen sind momentan in Deutschland nur auf dem Supercomputer Levante des DKRZ möglich. Es gibt zwar Computer mit einer höheren Rechenleistung, wie zum Beispiel JUWELS-Booster am Rechenzentrum in Jülich, die aber nicht den erforderlichen Arbeitsspeicher haben, um Konfigurationen dieses Ausmaßes zu bearbeiten.

Visualisierung und Prozessieren

Häufig sprechen Wissenschaftler:innen von einer neuen Generation der Klimamodellierung und beziehen dies auf die hohe Auflösung und die dadurch darstellbaren physikalischen Prozesse. Eine etwas versteckte Herausforderung besteht jedoch zusätzlich darin, eine neue Generation von Klimawissenschaftler:innen auszubilden, welche die resultierenden Datenmengen prozessieren und visualisieren können. Denn Klimamodelle mit diesen feinen Auflösungen produzieren enorme Datenmengen. Dies erfordert ein Überdenken und Anpassen des Speicherns und Weiterverarbeitens der Daten, da bisherige Arbeitsweisen nicht skalieren und damit nicht mehr praktikabel sind. Daten dieses Umfangs können beispielsweise nicht mehr so einfach zwischen Datenzentren transferiert werden. Aus diesem Grund bieten Rechenzentren Methoden und Ressourcen an, mit denen Daten direkt vor Ort ausgewertet werden können. Weitere Anpassungen der Arbeitsweisen werden notwendig sein, um Modelle mit Kilometer-Skalen in der Klimaforschung zu etablieren. Neue Datenformate, das Streamen der Simulationsdaten zu weiterverarbeitenden Programmen, innovatives Komprimieren mit der Nutzung von AI-Methoden, interaktives Arbeiten und das Erstellen von Visualisierungen innerhalb des Modells schon während der Simulation werden momentan getestet. Eine Schlüsselkomponente bildet hierbei die Möglichkeit, nur auf Teile eines großen Datensatzes zugreifen zu können und gezielt nur die benötigten Daten zur Visualisierung und Weiterverarbeitung in den Speicher zu laden. Ziel ist es, einen datenzentrierten Workflow zu entwickeln, welcher Informationen sichtbar, zugänglich und interoperabel macht.

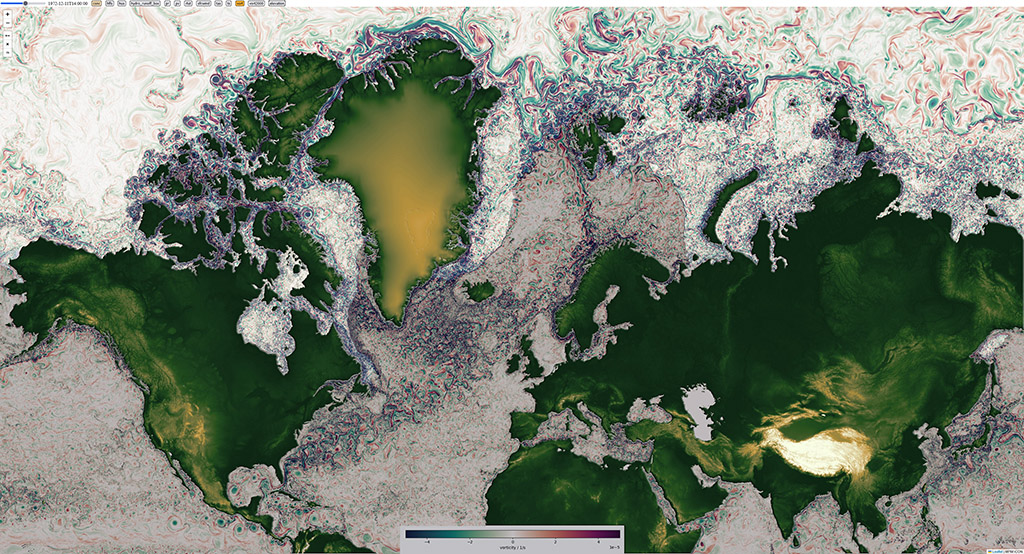

Abbildung 2: Die Visualisierung zeigt die Wirbelstärke (Vorticity) im Ozean in unterschiedlichen Helligkeiten für den eisbedeckten und den eisfreien Ozean. Zusätzlich ist auf den Landflächen eine Falschfarbdarstellung der ICON-Modelltopographie in das Bild eingefügt worden. Die einzelnen Bildteile stammen aus einem neuartigen interaktiven Visualisierungstool, was am MPI-für Meteorologie für den interaktiven Zugang zu den extrem hochaufgelösten und umfangreichen Modelldaten entwickelt wird.

Ausblick

Diese neue, hochaufgelöste und physikalischere Generation von Klimamodellen wird einige bisher ungelöste Fragen zu Prozessen auf der Kilometer-Skala angehen. Gekoppelt mit einer innovativen Datenverarbeitung wird dieser Weg zu neuen Fragestellungen und Erkenntnissen in der Klimaforschung führen.

Die aktuellen Entwicklungen sind Teil des BMBF-geförderten Projekts WarmWorld, wie auch der EU-geförderten Projekte nextGEMS, EERIE und DestinE und tragen über letzteres auch zu der Idee bei, einen digitalen Zwilling des Erdsystems zu entwickeln.

Kontakt

Max-Planck-Institut für Meteorologie (MPI-M), Bundesstraße 53, 20146 Hamburg: Daniel Klocke, Angel Peinado, René Redler, Leonidas Linardakis, Luis Kornblueh, Tobias Kölling

Deutsches Klimarechenzentrum (DKRZ), Bundesstraße 45a, 20146 Hamburg: Jan-Frederik Engels