![]() Das AIM-Team am DKRZ unterstützt Forschende aus verschiedenen Helmholtz-Zentren bei der Einführung, Evaluation und dem praktischen Einsatz von ML/AI-Technologien, beispielsweise von künstlichen neuronalen Netzen (kNNs) oder Entscheidungsbäumen (random forests).

Das AIM-Team am DKRZ unterstützt Forschende aus verschiedenen Helmholtz-Zentren bei der Einführung, Evaluation und dem praktischen Einsatz von ML/AI-Technologien, beispielsweise von künstlichen neuronalen Netzen (kNNs) oder Entscheidungsbäumen (random forests).

In der Praxis wenden sich Nutzerinnen und Nutzer aus den entsprechenden „Erde und Umwelt“-Helmholtz-Einrichtungen mit ihren Anfragen an die AIM-Gruppe. Das Spektrum der Anfragen variiert in Komplexität, und dem damit verbundenen Arbeitsaufwand: von der Beantwortung technischer oder methodischer Fragen bis hin zur Planung, Implementierung und Durchführung komplexer ML-Workflows.

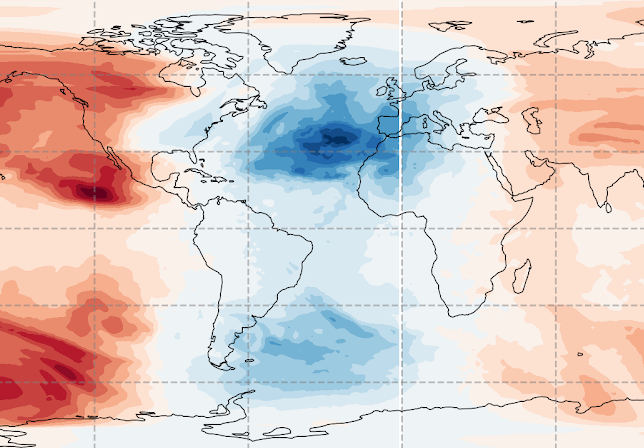

Die Methoden der künstlichen Intelligenz und des maschinellen Lernens bieten für die Klimamodellierung und Klimadatenanalyse eine Reihe vielversprechender Möglichkeiten. Der für die Durchführung von Klimasimulationen erforderliche Rechenaufwand steigt mit der immer höheren Auflösung der Klimamodelle, welche wiederum notwendig ist, um kleinskalige Prozesse wie etwa Wolkenentstehung realitätsgetreuer abzubilden. Mithilfe der Methoden des maschinellen Lernens sollen einerseits Modellberechnungen mit weniger Rechenaufwand und damit schneller durchführbar werden, und andererseits sollen die Qualität der Ergebnisse verbessert oder auch bisher unbekannte Regelmäßigkeiten und Muster in den berechneten Daten entdeckt werden.

Die Methoden klingen hierbei für Außenstehende oft nach unerklärbarer Magie, auch aufgrund plakativer Beispiele großer Industriekonzerne wie Facebook oder Google. Diese bilden jedoch oft nur einen kleinen Spezialbereich von den Möglichkeiten künstlicher Intelligenz ab, wie etwa die automatische Generierung und Ergänzung von Bildern. Die dahintersteckenden Algorithmen sind komplex und erfordern eine immense Menge an Trainingsdaten und Optimierung, damit der beabsichtigte Lerneffekt eintreten kann. Für Projektionen der zukünftigen globalen Durchschnittstemperatur bis ins Jahr 2100 sind aufwändige Berechnungen mit einem komplexen Klimamodell erforderlich. Wird ein maschinelles Lernverfahren einfach mit einer Temperaturkurve der vergangenen 170 Jahre konfrontiert, kann es auch nicht die Fortsetzung der Kurve bis ins Jahr 2100 quasi ‘magisch’ abliefern. Es benötigt große Mengen an komplexen Trainingsdaten und muss schrittweise entwickelt werden, bis es eine akzeptable Ergebnisqualität erreicht. Eine typische Herausforderung ist dabei, dass ein Modell sich zu eng an die vorgegebenen Daten anpasst und schlecht verallgemeinert (overfitting).

Die ML-Anfragen werden durch das AIM-Team iterativ bearbeitet. Zuerst werden eine Modellarchitektur, Datenverarbeitung und operative Umgebung entwickelt, beispielsweise für das automatisierte Ausführen und die Optimierung von Modellparametern – sogenanntes Hyperparametertuning. Diese werden in kurzen Zyklen getestet und die Ergebnisse werden gemeinsam mit den zu unterstützenden Wissenschaftlerinnen und Wissenschaftlern evaluiert. In diesem Zyklus werden die ML-Methoden stetig weiterentwickelt, bis sie zufriedenstellende Ergebnisse liefern. Die Zielsetzungen können hierbei vielfältig sein, etwa immer bessere Genauigkeit von Vorhersage oder Regression zu erhalten, die reine Rechenleistung – in diesem Fall die Zeit für einen Trainingslauf – zu verbessern bzw. zu verringern, aber auch verschiedene Verfahren miteinander zu vergleichen, etwa neuronale Netze mit Entscheidungsbäumen.

Nach knapp einem Jahr seines Bestehens deckt das AIM-Team am DKRZ bei den bearbeiteten Anfragen eine große Themenbandbreite der Klima- und Umweltforschung aus verschiedenen Helmholtz-Zentren ab. Im Folgenden werden zwei bereits länger laufende Projekte vorgestellt, die den fortschreitenden Einsatz von ML-Methoden und ihren Nutzen für die Klimaforschung demonstrieren und weiteres Innovationspotenzial aufzeigen.

FastChem: Untersuchung von ML-Methodik für die Atmosphärenchemie

Die Modellierung chemischer Prozesse in der Erdatmosphäre, beispielsweise die Ozonchemie der Stratosphäre, ist von essentieller Bedeutung für das Gesamtverständnis von Abläufen und Änderungen im Erdsystem - sowohl für die Vergangenheit als auch für die Zukunft. Gekoppelte Klimamodelle, welche die atmosphärische Chemie mit simulieren, sind jedoch sehr rechenaufwändig, und werden daher kaum in Szenarienrechnungen eingesetzt.

Auf Anfrage des Instituts für Meteorologie und Klimaforschung des KIT untersucht das AIM-Team aktuell, inwieweit sich die Ausgabe eines Modells für atmosphärische Chemie durch maschinelles Lernen erlernen und emulieren lässt, und wie sich die erlernten ML-Methoden in operative Klimamodelle zukünftig integrieren lassen. Das Ziel ist, durch den Einsatz eines ML-Verfahrens den Rechenaufwand bzw. die Rechenzeit zu minimieren und dabei den Ergebnissen des dynamischen Chemiemodells möglichst nahe zu kommen.

Als ML-Verfahren kommen hierbei künstliche neuronale Netze zum Einsatz. Da ein bereits vorhandenes Modell hinsichtlich seiner Ergebnisse nachgeahmt werden soll, ist die sonst für ML-Problemstellungen häufige Hürde einer nur begrenzt vorhandenen Verfügbarkeit von Trainingsdaten in diesem Fall kein Problem: Mehr Daten (Ein- und Ausgabe des vorhandenen Modells) lassen sich vergleichsweise einfach und in großer Menge erzeugen.

Die Komplexität und Eigenarten der Daten stellt in diesem Fall die größere Herausforderung dar als etwa eine komplexe Architektur des verwendeten künstlichen neuronalen Netzes. So ist das Netzwerk relativ einfach, enthält wenige Schichten und es kommen zum Beispiel derzeit weder bildwahrnehmende (convolutional) noch rückgekoppelte (recurrent) Schichten zur Abbildung räumlicher oder zeitlicher Muster zum Einsatz. Die besonderen Herausforderungen liegen vielmehr darin, dass die Daten Werte von 110 chemischen Komponenten beinhalten, welche alle individuelle statistische Verteilungen aufweisen und an diversen Reaktionen beteiligt sein können.

Eine weitere Herausforderung stellt die große Menge an Daten dar, seitdem das Training von Daten einzelner Zeitschritte zu zeitabhängigen Daten für einen 3-Monats-Zeitraum ausgeweitet wurde. Die Datenmenge übersteigt hierbei mittlerweile die Größe des Speichers der auf dem DKRZ-Supercomputer Mistral verfügbaren Grafikprozessoren (GPUs). Dadurch sind deutlich komplexere Strategien notwendig, um das Training weiterhin mit guter Leistung und Auslastung der Prozessoren durchführen zu können. Im Hinblick auf eine weitere Verbesserung der Ergebnisqualität werden wahrscheinlich zukünftig nochmals mehr Daten erforderlich sein, so dass ein grundsätzlich anderer Umgang mit dem Ablauf der Datentransfers innerhalb des Hochleistungsrechners erforderlich wird. In diesem Zusammenhang werden auch Erkenntnisse aus dem zweiten Beispiel immer bedeutsamer.

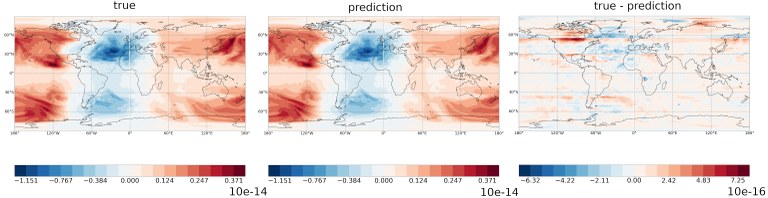

Die Ergebnisse der ersten prototypischen Umsetzungen zeigen, dass sich die Berechnungen des dynamischen Chemiemodells generell mit einem künstlichen neuronalen Netz nachbilden lassen, jedoch noch beschränkt auf eine kleine Untermenge chemischer Komponenten, und dass mit der Zeit steigende Abweichungen auftreten. Obwohl das Training sehr rechenaufwändig ist, zeigt eine erste Abschätzung, dass nach einem Training des Netzwerks seine Einbindung in ein operatives Klimamodell keinen hohen Rechenaufwand erfordert. Damit erscheint die ursprüngliche Zielsetzung grundsätzlich erreichbar. Bis zu einer tatsächlichen Umsetzung in einem operativen Modell ist es noch ein weiter Weg, der zwar vielversprechend erscheint, aber auch deutlich über das hinausgeht, was vom AIM-Team an Unterstützung geleistet werden kann.

Abb. 1: Die Vorhersage des ML-Modells (Mitte) im Vergleich mit der Ausgabe des Ursprungsmodells (links) für atmosphärisches HNO3 (Salpetersäure). Der Fehler zwischen den beiden Ausgaben (d.h., die Differenz [rechts]) ist zwei Größenordnungen niedriger und somit in einem akzeptablen Bereich.

Workflow-Optimierung und Benchmarking für hochaufgelöste und großvolumige Klimamodelldaten

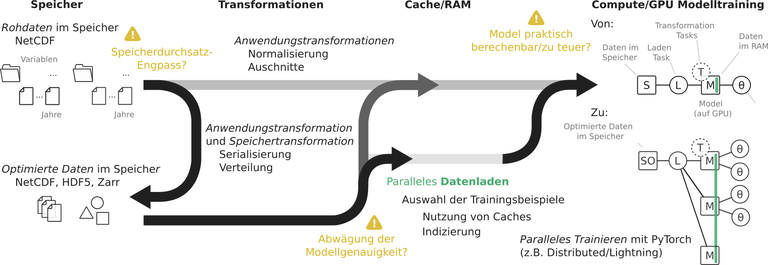

Wie auch im ersten Beispiel soll eine langfristige Perspektive für die Anwendung von ML-Verfahren in der Klimamodellierung entwickelt werden, so dass künstliche neuronale Netze (kNNs) mit einem bestehenden gekoppelten Klimamodell zusammengebracht und mit diesem zusammen im Rahmen von Simulationen auf High-Performance-Computing-Systemen (HPC-Systemen) eingesetzt werden. Eine der technischen Herausforderungen, die sich aus solchen Einsatzszenarien ergeben, betrifft die optimale Nutzung der teuren GPU-Knoten. Wie lassen sich GPU-Knoten optimal mit Daten beschicken, sodass sie keinen Leerlauf haben und Rechenzeit optimal genutzt wird? Diese Frage stellt sich sowohl bereits beim Training von kNNs mit großen Klimadatenmengen als auch bei der langfristigen Kopplung von Klimamodellen mit kNNs, wie im vorigen Beispiel beschrieben. Das Problem beim Einsatz von kNNs liegt darin, dass bei ihrem Training nahezu zufällig sehr kleine Datenmengen aus den viele Größenordnungen umfangreicheren Datensätzen abgefragt werden müssen. Aufgrund ihrer Größe werden diese Daten auf Festplatten gespeichert. Der Weg der Daten zu den GPUs führt somit über mehrere Schritte im HPC-System: nach dem Laden in den Hauptspeicher eines Rechnerknotens müssen diese in den Speicher der GPU übertragen werden, ähnlich einer Pipeline mit mehreren Zwischenstationen. Alle diese Stellen haben einerseits einen begrenzten Durchsatz an Datenvolumen, das pro Sekunde transferiert werden kann, und andererseits gibt es Begrenzungen in der Gesamtmenge an Daten, die gespeichert werden kann. Für die Optimierung des Durchsatzes der GPUs müssen folglich auch die verschiedenen Stellen des Datenweges optimiert werden. Dafür ist es erforderlich, zunächst auszumessen, welche Bandbreite an den verschiedenen Stellen erreicht und wodurch sie begrenzt wird, wenn die GPU verschiedene Aufgaben ausführt, sodass die verschiedenen Optimierungsziele gegeneinander abgewogen werden können.

Abb. 2: Eine Übersicht der verschiedenen Schritte von den Rohdaten (links) zu den Trainingsdaten, mit denen sich ein kNN trainieren lässt (rechts). Hervorgehoben sind außerdem potenziell abzuwägende Optimierungsziele, die sich aus begrenzten Ressourcen wie Speicher- oder Rechendurchsatz ergeben.

Konkret sollten im Rahmen dieser Anfrage des Instituts für Küstenforschung des Helmholtz-Zentrums Geesthacht (HZG) typische Zugriffsmuster eines kNNs systematisch - unter anderem auf der Mistral - durchgetestet werden: von den GPUs, auf denen es läuft, bis zu den Festplatten, wo die benötigten Daten liegen. Als Anwendungsfall kam hierbei der WeatherBench-Datensatz (Rasp et al. 2020) zum Einsatz, welcher repräsentativ für typische Klimamodelldaten steht und für derartiges Benchmarking gut vorbereitet und dokumentiert ist. Abgesehen von der Durchführung der Benchmarks sollten Codebausteine zum Aufbau und Ausführen einer solchen vollständigen Daten-Pipeline angefertigt werden sowie Empfehlungen zur möglichen Optimierung ähnlicher Probleme gemacht werden.

Eine Erkenntnis aus diesem Prozess ist, dass die größten Hindernisse oft beim nahezu zufälligen Zugriff auf Daten auf den Festplatten liegen. Es gibt verschiedene Strategien, damit umzugehen. So könnte beispielsweise das Laden der Daten auf dedizierte Knoten ausgelagert werden, um so die vergleichsweise schnelle Netzwerkanbindung zwischen Prozessor- und GPU-Knoten in Kombination mit einer weniger zufälligen Befütterung des Netzwerks auszunutzen. Eine wissenschaftliche Publikation hierzu ist in Vorbereitung.

Die vorgestellte Unterstützung durch das AIM-Team am DKRZ können Nutzerinnen und Nutzer der Helmholtz-Gemeinschaft aufgrund der Förderung durch Helmholtz AI kostenlos in Anspruch nehmen. Für alle weiteren Interessenten bietet das DKRZ eine allgemeine Beratung bei diesen Themen.

Autoren:

Dr. Tobias Weigel, Jakob Lüttgau, Dr. Caroline Arnold, Dr. Frauke Albrecht, Felix Stiehler

Kontakt:

Y29uc3VsdGFudC1oZWxtaG9sdHouYWlAZGtyei5kZQ==

Weblinks und weiterführende Informationen:

- Mehr Informationen über das AIM-Unterstützungsteam: https://www.helmholtz.ai/themenmenue/our-research/consultant-teams/helmholtz-ai-consultants-hzg/index.html

- Unterstützungsanfragen können auch direkt an Helmholtz AI gerichtet werden: https://www.helmholtz.ai/themenmenue/our-model/funding-lines/voucher-system/index.html

- Helmholtz AI-wow!-Videos: Videoreihe, in der Wissenschaftlerinnen und Wissenschaftler in weniger als einer Minute grundlegende AI-Fachbegriffe erklären: https://vimeo.com/helmholtzai/videos

- Helmholtz AI: https://helmholtz.ai/

- Nachwuchsforschungsgruppe am HZG: http://m-dml.org/

Literatur:

Rasp, S., Dueben, P. D., Scher, S., Weyn, J. A., Mouatadid, S., & Thuerey, N. (2020). WeatherBench: A benchmark dataset for data-driven weather forecasting. ArXiv:2002.00469 [Physics, Stat]. http://arxiv.org/abs/2002.00469